2016-2022 All Rights Reserved.平安财经网.复制必究 联系QQ 备案号:

本站除标明“本站原创”外所有信息均转载自互联网 版权归原作者所有。

邮箱:toplearningteam#gmail.com (请将#换成@)

前一段时间Open AI也做出了一系列神级的操作,利用GPT钢4对于GPT-2出现的行为解释,大型语言模型及涌现的能力和运作的方式像黑箱一样,是没有人能够知晓如何出现的。语言模型在近期有着巨大的进步,通过上下文的学习对获得的任务进行执行。

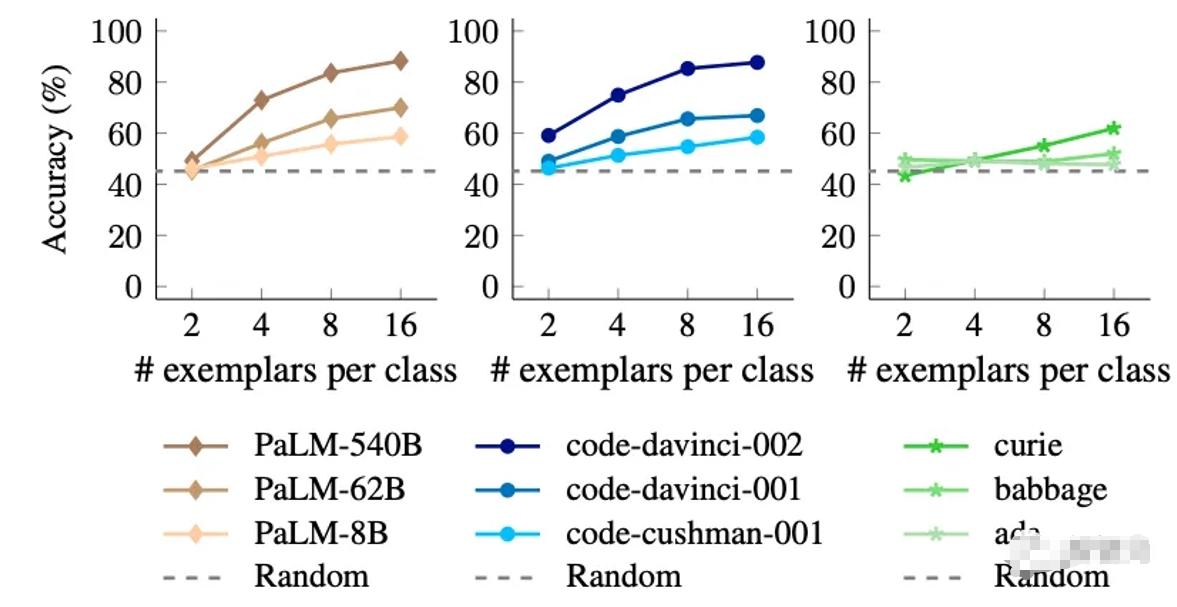

上下文的学习是一种学习的过程,对没有见过的样品进行评估,执行具体的任务前会对于输入的标签先接收并对应,语言模型上下文在学习方面产生的能力会跟随参数的变化而出现相应的改变。大型大语言模型遵循上下文当中给出的范例,即使标签与意义上并没有相关联的特点或者被翻转,这样的能力在小型的语言模型当中是根本不存在的现象。

模型之所以可以在上下文当中能够学习,一方面在利用之前预先进行训练的语文知识对标签作出一定程度的预测,并且依据上下文给出具体模板的范例,而另一种就是在提供所有的例子当中,学习中的输入-标签映射出来。新所进行的研究及目标就是为了将这两个因素对上下文中的作用解释出来。覆盖先前验证的知识是模型,规模具备的能力,和上下文中学习到和寓意并没有太相关联的标签具有的能力是一样的。

研究人员在做实验的时候,利用语义无关的标签,将原本的标签作为替代,在进行这种替换之后,语义无关的标签,使得小型模型性能方面有较大幅度的下降, 而当语义标签所具有的特性被移除掉之后,大模型可以在上下文当中对输入标签映射的能力具备相比于小型模型来说,上下文的范例对于大模型在使用性能上面改善是很大的。

2016-2022 All Rights Reserved.平安财经网.复制必究 联系QQ 备案号:

本站除标明“本站原创”外所有信息均转载自互联网 版权归原作者所有。

邮箱:toplearningteam#gmail.com (请将#换成@)